基于对抗神经网络ISRGAN的多源遥感数据融合与超分辨模型

研究背景

详细和准确的土地覆盖和土地利用空间变化信息是地方生态和环境研究的重要基础。为了完成这些任务,需要高空间分辨率的图像来捕捉地球表面的时空动态变化。目前,获取高时空分辨率影像的方法主要有两种:1)多源影像融合模型;2)影像超分辨率模型。

与图像融合模型相比,超分辨模型无需在相近时间内获取同一区域的高空间分辨率影像,因此在计算机视觉和遥感领域的多种场景中具有更强的适用性。

图像超分辨率模型的基本假设是:如果低空间分辨率图像是通过某种重采样过程生成的,那么可以通过重建或从其他高空间分辨率图像中学习,恢复低分辨率图像中缺失的细节。基于这一假设,过去十年中,研究者们致力于准确预测点扩散函数(PSF),即形成低分辨率像素的混合过程。目前主要有三种方法:1)基于插值的方法;2)基于重构的方法;3)基于学习的方法(见表 1)。

首先,插值法是基于一定的数学策略,从相关点计算要恢复的目标点的像素值,其复杂度低,效率高。但是,得到的图像的边缘效果很明显,在插值过程中没有产生新的信息,无法恢复图像的细节。

其次,重构法对成像过程进行建模,整合来自同一场景的不同信息,获得高质量的重构结果。通常这些方法为了提高空间分辨率而牺牲时间分辨率,需要预先配准和大量的算力。

第三,学习法克服了难以确定重建方法的分辨率改进倍数的限制,可以面向单一图像,这是目前超分辨率重建的主要发展方向。在这类方法中,常用的方法有近邻嵌入法、稀疏表示法和深度学习法。

表 1超分辨方法对比

| 方法大类 | 模型 | 基本思想 | 优点 | 缺点 |

|---|---|---|---|---|

| 插值法 | 最近邻插值法,二次卷积法,三次卷积法 | 当前像素值可以用邻近的像素表示 | 复杂度低,效率高 | 图像纹理细节无法预测 |

| 重构法 | 联合地图配准,PSF反卷积,稀疏回归法 | 通过重建技术恢复图像物理性质和特征,使点扩散函数进一步恢复图像细节 | 融合同一场景的不同信息,得到高质量重建结果 | 配准需要耗费大量计算时间 |

| 学习法 | 邻域嵌入法,稀疏表达法,贝叶斯网络,SRCNN,SRGAN | 通过学习大量图像样本,创建点扩散函数 | 样本数量较多时生成的图像更接近目标图像,获得更高的PSNR | 训练时间长,需要大量数据集,模型泛化能力差 |

学习法通常需要高度代表性的训练样本来覆盖总体数据的变化。在实际操作中,为了达到这一目标,通常需要收集大量的训练样本。然而,在遥感领域,几乎不可能准备这样的大规模训练样本集,因为遥感数据的变化不仅取决于目标的变化,还受到不同位置和不同卫星传感器的影响。由于这一限制,许多基于学习的方法都局限于某个特定位置和传感器,导致模型在跨区域和跨传感器上的泛化能力不足。这一问题仍然是为不同区域和传感器训练通用超分辨率模型的主要挑战。

近年来,随着人工智能特别是基于神经网络的深度学习方法的快速发展,深度学习在处理大样本集并保持良好泛化能力方面展现了显著优势,并在计算机视觉领域得到了广泛应用。在图像超分辨率领域,Dong于2014年首次提出了超分辨率神经网络SRCNN ^[16]^ 。与传统方法相比,该方法在峰值信噪比(PSNR)上表现更优,但当采样率较高时,重建图像会显得过于平滑,导致细节丢失。为了解决这一问题,Ledig等人提出了超分辨率生成对抗网络模型SRGAN,将原始CNN结构替换为GAN ^[17]^ 。作为深度学习领域的最新模型,SRGAN在捕获大样本的高维非线性特征方面表现出许多优势。然而,SRGAN模型在不同位置和传感器的遥感图像上的泛化能力仍有待验证。

在本研究中,我们验证了基于GAN的方法可以提高模型在跨区域和跨传感器上的泛化能力。通过对SRGAN模型进行一些改进,可以实现一次性训练,并将结果应用于不同区域和传感器。本研究的主要贡献如下:

1)在SRGAN的基础上,提出了ISRGAN模型,解决了SRGAN训练不稳定以及模型泛化能力弱的问题;

2)通过计算模型在广东GF1数据集和新疆GF1数据集上的定量指标并进行t检验,验证了模型在跨区域上的普适性;

3)通过计算模型在新疆GF1数据集和新疆Landsat8数据集上的定量指标并进行t检验,验证了模型在跨传感器上的普适性;

4)以应用服务为目标,将超分辨后的遥感图像应用于土地覆盖分类和地物提取,提高分类及地物提取精度。

模型跨区域和跨传感器超分辨结果分析

基于广东高分1号数据集上训练的ISRGAN超分辨模型,我们分别迁移到新疆高分1号数据集、新疆Landsat8数据集上进行模型的跨区域,跨传感器测试。测试部分结果分别如图2.1.2~图2.1.4所示。

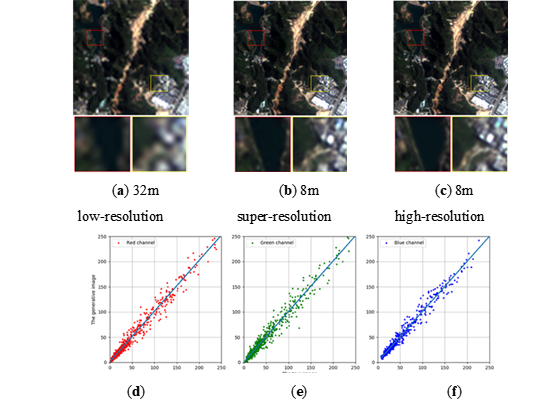

图 2.1.2在广东训练完成的ISRGAN模型在广东本地GF1数据集超分辨率测试结果(a)输入的图像;(b)超分辨图像;(c)地面真值;(d)(e)(f)分别表示超分辨图像真实图像在红、绿和蓝三波段1:1灰度图,斜率分别为1.0063,1.0032和0.9955。

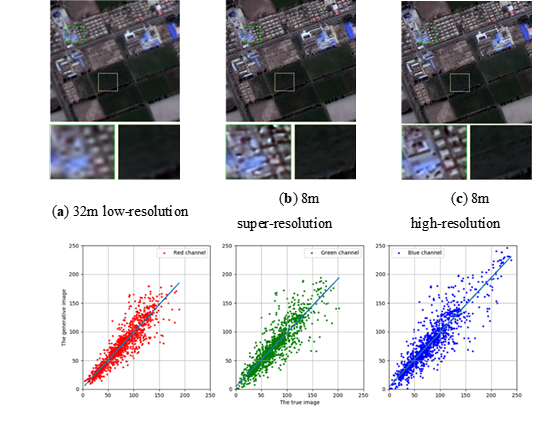

图 2.1.3模型跨区域检验:在广东训练完成的ISRGAN模型直接迁移到新疆GF1数据集超分辨率测试结果(a)输入的图像;(b)超分辨图像;(c)地面真值;(d)(e)(f)分别表示超分辨图像真实图像在红、绿和蓝三波段1:1灰度图,斜率分别为0.9658,0.9378和0.9485。

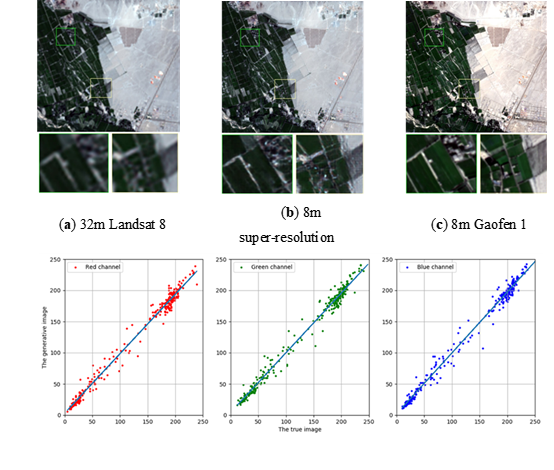

图2.1.4模型跨传感器检验:将广东训练完成的ISRGAN模型在直接迁移到新疆Landsat数据集的超分辨率测试结果(a)输入的图像;(b)超分辨图像;(c)地面真值;(d)(e)(f)分别表示超分辨图像真实图像在红、绿和蓝三波段1:1灰度图,斜率分别为0.9527,0.9564和0.9760。

与传统超分辨模型对比试验

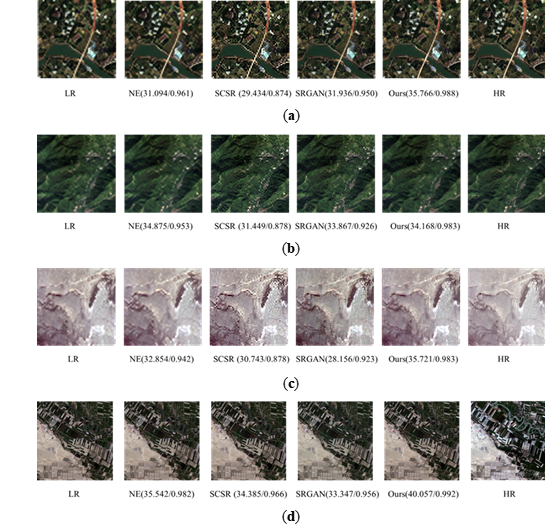

本文主要对比了超分辨领域经典方法领域嵌入法及稀疏表达法,根据相应的超分辨结果,计算其与原始图像的定量化指标,在本文中,由于同一时间同一场景下的Landsat8卫星数据和高分一号卫星数据很难获取,而且其对应的像元个数不一致,考虑到后续在验证模型在跨区域和跨传感器上的普适性上计算标准的一致性,故本文的所有定量计算的参考影像均为超分辨之前的原始影像,计算方法为将超分辨后的影像进行相应的降采样处理,再计算其与原始影像的量化指标。图2.1.5展示了本文基于ISRGAN方法和领域嵌入法、稀疏表达法及SRGAN在3个测试集中测试的部分对比结。

结论

本文以生成对抗网络在计算机视觉中的超分辨算法为基础,针对生成对抗网络在训练时存在的梯度消失和模式崩坏等问题,结合WGAN中提出的最小化Wasserstein距离的方法,对原始超分辨网络(SRGAN)进行了改进,提出了ISRGAN网络,并将其应用于遥感影像超分辨。主要结论如下:

1)本文提出的ISRGAN超分辨网络,在遥感影像超分辨任务中,定量指标优于领域嵌入法和稀疏表达法等传统方法;

2)通过在广东GF1影像数据上训练的模型直接应用于新疆GF1影像数据,并对两组数据集的超分辨结果进行t检验,验证了模型在跨区域上的普适性;

3)通过在高分1数据上训练的模型直接应用于Landsat8数据,并对超分辨结果进行t检验,验证了模型在跨传感器上的普适性;

4)以土地利用分类和地物提取为例,验证了超分辨影像在分类和提取精度上的显著提升,表明遥感影像超分辨在资源开发、环境监测、灾害研究和全球变化分析等方面具有重要应用价值。

原文链接

Xiong, Y., Guo, S., Chen, J., Deng, X., & Sun, L. (2020). Improved SRGAN for Remote Sensing Image Super-Resolution Across Locations and Sensors. Remote Sensing, 12(1263), 1–22. https://doi.org/10.3390/rs12081263

Enjoy Reading This Article?

Here are some more articles you might like to read next: